米乐 M6米乐MATLAB残差神经网络设计

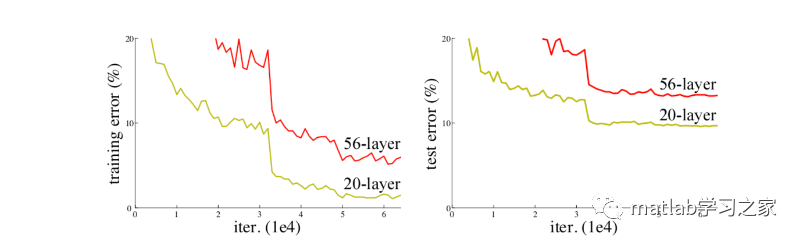

中,输入的是图片的矩阵,也是最基本的特征,整个CNN网络就是一个信息提取的过程,从底层的特征逐渐抽取到高度抽象的特征,网络的层数越多也就意味这能够提取到的不同级别的抽象特征更加丰富,并且越深的网络提取的特征越抽象,就越具有语义信息。但越深真的越好吗?我们可以看下面一张图片,图中描述了不同深度的传统神经网络效果对比图,显然神经网络越深效果不一定好。

对于传统CNN网络,网络深度的增加,容易导致梯度消失和爆炸。针对梯度消失和爆炸的解决方法一般是正则初始化和中间的正则化层,但是这会导致另一个问题,退化问题,随着网络层数的增加,在训练集上的准确率却饱和甚至下降了。为此,残差神经网络应运而生。

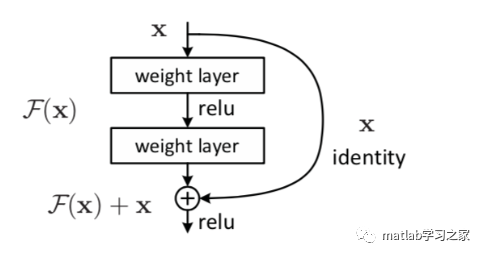

普通的平原网络与深度残差网络的最大区别在于,深度残差网络有很多旁路的支线将输入直接连到后面的层,使得后面的层可以直接学习残差,这些支路就叫做shortcut。传统的卷积层或全连接层在信息传递时,或多或少会存在信息丢失、损耗等问题。ResNet 在某种程度上解决了这个问题,通过直接将输入信息绕道传到输出,保护信息的完整性,整个网络则只需要学习输入、输出差别的那一部分,简化学习目标和难度。

模型,想在labview中调用,请问应该怎么做呢?或者labview有自己的

的工作原理,可以理解为:通过注意力机制注意到不重要的特征,然后通过软阈值化将它们置为零;或者说,通过注意力机制注意到重要的特征,将它们保留下来,从而加强深度

模型用于训练的输入数据:对应的输出数据:我们这里设置:1:节点个数设置:输入层、隐层、输出层的节点

的远程监米乐 M6米乐督关系抽取方法提取的特征单一,且标准交叉熵损失函数未能较好处理数据集中正负样本比例不均衡的情况。为此,提出一种基于深度

STM32G474 基于STM32Cubemx HAL 库实现 DMA 驱动 GPIO 高速翻转

运用升降压充电芯片IU5180实现Type-c给1-4节锂电池快速充电

基于DWC2的USB驱动开发-0x09 ULPI接口协议其他工作模式介绍

扫一扫关注微信公众帐号